英伟达的最强对手来了!拟IPO公司声称芯片速度快20倍

过去三年,英伟达从一家小众半导体公司发展成为全球市值最高的公司。其迅速崛起背后的催化剂可以用三个字母来概括:GPU。

英伟达的图形处理单元 (GPU) 已成为人工智能 (AI) 革命的引擎——为从大型语言模型 (LLM) 到自动驾驶汽车、机器人和高端视频渲染等一切事物提供动力。

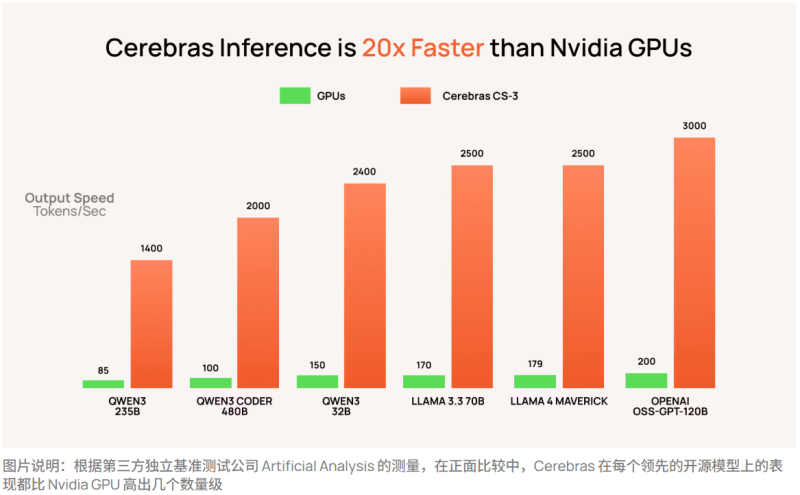

然而,尽管英伟达的主导地位似乎不可动摇,但一个挑战者正在出现。初创公司Cerebras大胆宣称,其芯片能够以比英伟达硬件快20倍的速度驱动AI模型。投资者不禁要问,英伟达的统治地位最终是否会面临一个强有力的竞争对手?

Cerebras晶圆级芯片解析:人工智能的巨型引擎

要了解Cerebras为何引起如此大的关注,投资者需要了解它是如何打破传统芯片设计规则的。

英伟达的GPU体积虽小,但功能强大,必须进行集群化(有时需要数万个)才能执行训练现代AI模型所需的海量计算。这些集群提供了令人难以置信的性能,但也带来了效率低下的问题。每个芯片都必须通过高速网络设备不断地将数据传递给相邻的芯片,这会导致通信延迟、能源成本上升,并增加技术复杂性。

Cerebras颠覆了这一模式。它不再连接数千个小型芯片,而是拥有一个与整个硅片大小相当的巨型处理器——恰如其分地命名为“晶圆级引擎”。在这片硅片内,数十万个核心无缝协作。由于一切都在统一的架构上进行,数据不再需要在芯片之间传输——这显著提高了速度,同时降低了功耗。

为什么Cerebras认为它可以超越 英伟达

Cerebras的核心理念是效率。通过消除芯片间通信的需求,其晶圆级处理器将整个AI模型集成在单个芯片中,从而减少了时间和功耗的浪费。

这就是Cerebras声称性能提升20倍的由来。这一突破并非源于原始时钟速度,而是在于简化数据移动方式并消除瓶颈。

这种架构的实际优势在于简单。单个Cerebras系统无需管理、冷却和同步数万个GPU,只需占用一个机架即可部署,从而大幅节省AI基础设施成本。

英伟达为何仍占据主导地位

尽管大肆宣传,Cerebras仍然存在风险。制造如此大的芯片是一项工程难题。良率可能会波动,即使晶圆上任何地方的微小缺陷都可能损害处理器的很大一部分。这使得扩展晶圆级芯片模型既昂贵又不确定。

英伟达仍然是人工智能计算领域无可争议的领导者。除了强大的硬件之外,英伟达的CUDA软件平台还构建了一个根深蒂固的生态系统,几乎所有主要的超大规模计算平台都在此基础上构建其生成式人工智能应用程序。要取代这种竞争壁垒,需要的不仅仅是尖端的硬件——它需要企业彻底改变人工智能的设计和部署方式,迫使他们考虑转换成本带来的运营负担。

尽管如此,AI芯片的总体潜在市场正在快速扩张,为新架构与英伟达等现有架构共存留下了空间。例如,Alphabet的张量处理单元 (TPU) 专为深度学习任务量身定制,而英伟达的GPU则是多功能、通用的主力。这种动态表明,Cerebras可以在AI芯片领域开辟出自己的利基市场,而无需完全取代英伟达。

如何投资Cerebras

Cerebras此前曾考虑进行首次公开募股 (IPO),甚至在去年年底发布了S-1文件草案。然而,在最近一轮11亿美元的融资之后,该公司似乎搁置了IPO计划。目前,对Cerebra 的投资主要限于合格投资者、风险投资 (VC) 公司和私募股权基金。

对于日常投资者来说,更实际的方法是坚持投资老牌芯片领导者,如英伟达、AMD、台积电,或辅助合作伙伴,如博通或美光科技——所有这些公司都将受益于人工智能基础设施支出的爆炸式增长。

主编精选,篇篇重磅,请点击订阅“邮件订阅”

|

|